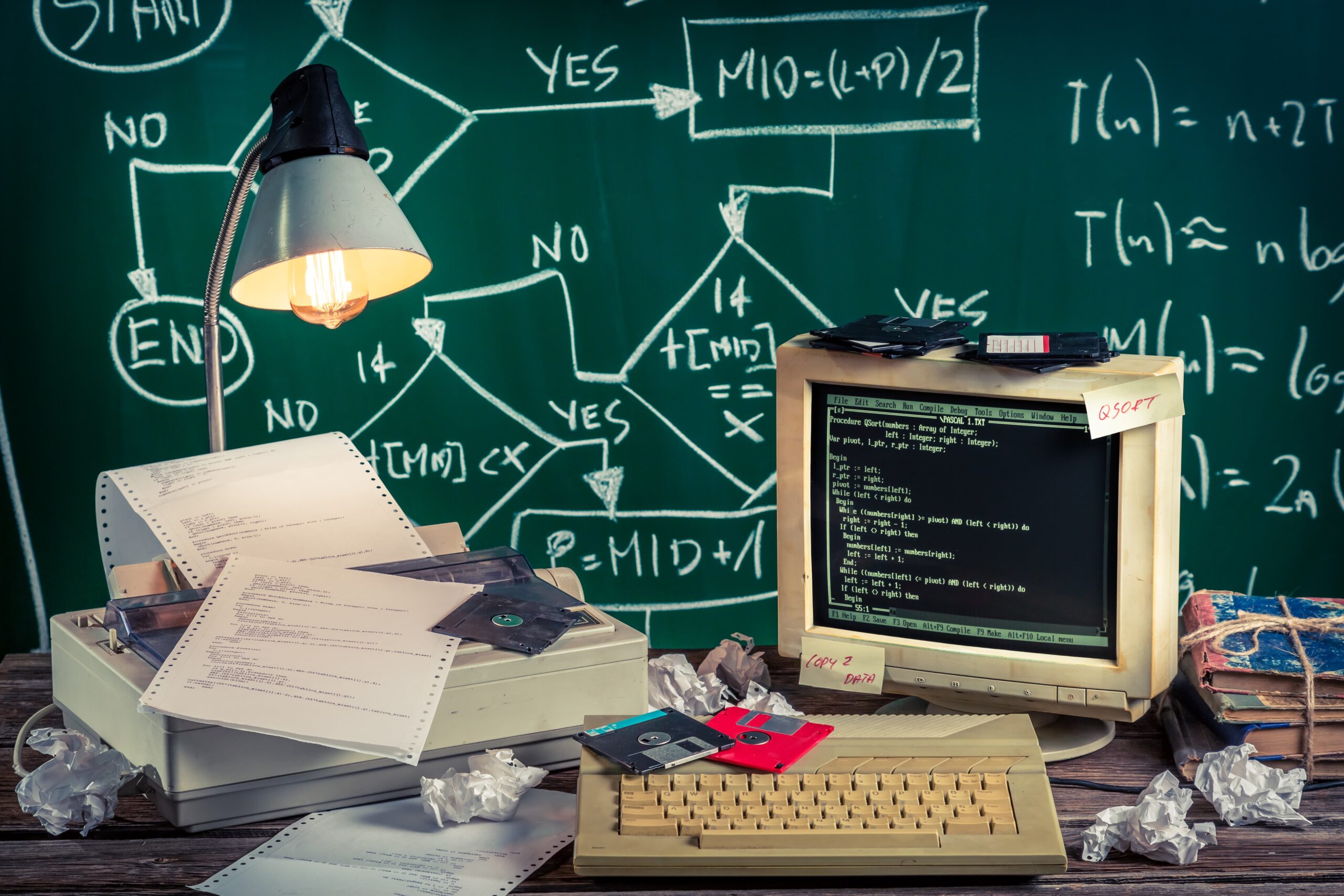

Si hay una rama del saber que ha marcado un antes y un después en nuestras vidas, esa es la informática. La presencia de ordenadores personales y de la tecnología posterior (tablets, teléfonos móviles y demás gadgets digitales) ha cambiado nuestra manera de vivir y de relacionarnos. Contamos con máquinas que procesan información a una velocidad desorbitada con la que nuestros bisabuelos no podían ni soñar. La historia de la informática es breve o casi tan extensa como la existencia del hombre, pero nos vamos a centrar en los últimos ochenta años.

¿Qué es la informática?

La informática o computación es el área del saber científico que investiga las distintas técnicas y métodos destinados al almacenamiento, procesamiento y transmisión de datos en soporte digital. Es una ciencia realmente extensa, que comprende desde la parte más matemática y densa, como algoritmos o teoría de la computación, hasta la implementación en el plano real de todo ese conocimiento a través del diseño de software y hardware, programación, análisis de datos, etcétera.

Historia de la informática

Años 40: de la ENIAC a Alan Turing

Durante los años cuarenta se desarrollaron los primeros ordenadores, como el Z3 y, sobre todo, el ENIAC, el primer ordenador programable. Su tecnología estaba basada en tubos de vacío y realizaba 5.000 operaciones aritméticas por segundo, algo ridículo si pensamos en cualquier dispositivo actual. La computadora ENIAC fue creada en Pensilvania y ocupaba todo un sótano de la Universidad de allí. Estos años también fueron en los que el matemático Alan Turing, que había sentado ya las bases de los algoritmos, desarrolló el test de Turing, que exploraba los límites de la inteligencia humana y de las computadoras.

Años 50: circuitos integrados y primeros lenguajes de programación

En esta década comenzó a operar la EDVAC, una computadora igualmente gigante, pero en sistema binario en lugar de decimal (como la ENIAC). Comienza a surgir la industria de la computación con IBM, que creó su primera computadora industrial y puso a la venta una impresora de matriz de puntos. En paralelo, se dieron muchos otros hitos: se desarrollaron varios lenguajes de programación, como COBOL o ALGOL, se construye el primer circuito integrado y nace la segunda generación de ordenadores, que sustituye los tubos de vacío por transistores.

Años 60: circuitos, disquetes y la espina dorsal de internet

En 1962 se crea el ordenador ATLAS, que introdujo infinidad de conceptos modernos en la historia de la informática, como la memoria virtual. Dos años después surge la tercera generación de computadoras, que basan su tecnología en circuitos integrados. Se desarrolló el lenguaje BASIC y el código ASCII (un estándar desde entonces). Además, por primera vez se aplica el concepto de redes de computadoras (ARPANET, el precursor de internet) y también se inventa el disquete, el primer soporte de almacenaje de datos digitales, así como el sistema UNICS, más tarde renombrado como Unix.

Años 70: los primeros ordenadores personales

En esta década aparece la memoria RAM, Intel desarrolla el primer microprocesador, aparecen las primeras hojas de cálculo y los primeros juegos para ordenador, comienza a investigarse sobre la transmisión de archivos a través de internet y se crea la impresora láser. Pero seguramente esta década será recordada porque aparecen los primeros ordenadores personales. Uno de ellos fue el Apple II, creado por Steve Jobs y Steve Wozniak. Nace Apple, pero un año antes había nacido Microsoft.

Años 80 y 90: nace internet

Nace el MS-DOS, el lenguaje de programación que se usaría durante los siguientes quince años. También se desarrolla el protocolo SMTP, que permitiría intercambiar correos electrónicos así como, el sistema de ventanas que hoy usamos todos en los ordenadores. Además, se crea el popular juego Tetris, aparece la popular tarjeta de sonido Sound Blaster… En 1990 se desarrolla el hipertexto que permitiría crear la World Wide Web, es decir, el protocolo de internet tal como lo conocemos hoy. También se desarrolla el protocolo de transmisión HTTP, los HTML y los URL. Durante los noventa aparecen los primeros navegadores de internet y en 1996 nace Internet2, más rápido que su predecesor.

Del 2000 hasta hoy

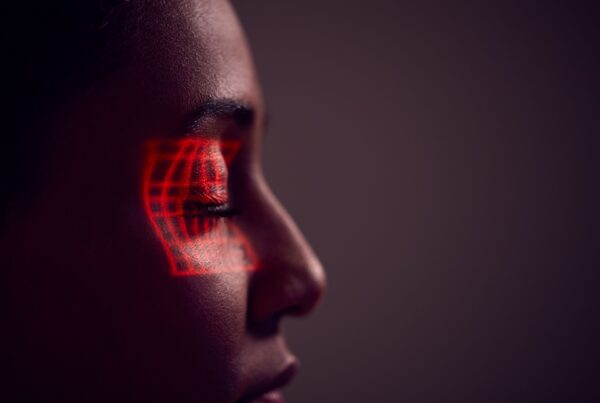

Aunque la tecnología avanza cada vez más rápido, los últimos años han sido en esencia de desarrollo y mejora de todo lo creado anteriormente en lo que a dispositivos se refiere. Los distintos sistemas operativos siguen perfeccionándose, así como las videoconsolas, que comenzaron a comercializarse en los noventa. Los grandes hitos del siglo XXI ha sido la aparición de la Wikipedia, el nacimiento de los primeros smartphones (con el iPhone 2G en 2007), las tablets, el e-book, los relojes inteligentes… Y lo que es más, comienza a desarrollarse el big data, la realidad virtual o el internet de las cosas.